Der Exzellenzcluster Science of Intelligence an der TU Berlin forscht zu neuen „Eventkameras“, die zukünftig in Robotern und Smartphones zum Einsatz kommen könnten.

Sechstausendmal höhere Kontraste als bei herkömmlichen Kameras, dafür potentiell wesentlich kleinere Dateigrößen der Bilder – sogenannte Eventkameras nehmen im Gegensatz zu herkömmlichen Kameras nicht ganze Bilder auf einmal auf, sondern registrieren für jedes lichtempfindliche Pixel getrennt nur die Veränderungen in der Helligkeit (die „Events“). Wissenschaftler*innen der TU Berlin, die gleichzeitig Mitglieder des Exzellenzclusters „Science of Intelligence“ (SCIoI) sind, forschen an neuen Methoden, mit der sich solche Aufnahmen auswerten lassen. Sie könnten Robotern das Sehen erleichtern, autonom fahrende Autos sicherer machen und vor allem in Smartphones zum Einsatz kommen.

Auch in der Digitalfotografie hat sich die grundsätzliche Methode, nach der Bilder aufgenommen werden, seit der ersten Belichtung einer fotografischen Platte im Jahr 1826 durch den Franzosen Joseph Niépce nicht geändert. Man lässt Licht für eine bestimmte Zeit auf einen lichtempfindlichen Sensor fallen und liest anschließend das Ergebnis aus: entweder durch das „Entwickeln“ von Filmmaterial oder durch Auslesen elektrischer Signale der lichtempfindlichen Pixel einer Digitalkamera. „Das Verfahren für optische Abbildungen, das sich in der Natur entwickelt hat, funktioniert dagegen ganz anders“, so Prof. Dr. Guillermo Gallego von der Fakultät IV „Elektrotechnik und Informatik“ der TU Berlin und leitender Wissenschaftler im Exzellenzcluster Science of Intelligence.

Inspiriert vom menschlichen Auge

Die „Zapfen“ und „Stäbchen“ in der Netzhaut des menschlichen Auges, die für das Farbensehen beziehungsweise eine empfindliche Helligkeitsunterscheidung zuständig sind, senden nach Lichteinfall sofort elektrische Nervenimpulse aus. Diese werden dann in der Netzhaut teilweise zusammengeschaltet, vorverarbeitet und das entstehende Signal schließlich ans Gehirn weitergeleitet. „Ähnlich funktionieren auch Eventkameras. Jedes einzelne, lichtempfindliche Pixel trägt zeitlich unabhängig zum Gesamtbild bei. Es gibt keine Belichtungszeit, nach der alle Pixel auf einmal ausgelesen werden, wie bei normalen Kameras“, erklärt Gallego. „Im Unterschied zum Auge lösen die Pixel aber nicht bei jedem Lichteinfall ein Signal aus, sondern nur, wenn sich die Helligkeit ändert. Das hat den Vorteil, dass die zu verarbeitenden Datenmengen vom Prinzip her wesentlich kleiner sind.“

Höherer Dynamikumfang

Einen der großen Vorteile der Eventkameras zeigt Gallego beim Vergleich mit einer normalen Videokamera, die auf seinen Schreibtisch vor dem Bürofenster gerichtet ist. Auf dem normalen Videobild ist nur der Schreibtisch selbst richtig belichtet, das Fenster dagegen hell überstrahlt und der Raum unter dem Schreibtisch völlig dunkel. Ganz anders die Eventkamera: Sie gewährt nicht nur einen Blick auf das Kabelgewirr unter der Tischplatte, sondern zeigt auch den realen Blick aus dem Fenster mit den Gebäuden gegenüber. Der Trick dahinter: Die Videokamera nimmt beispielsweise 30-mal in der Sekunde ein Bild mit der Belichtungszeit von einer sechzigstel Sekunde auf. Die Belichtungszeit wird dabei automatisch so eingestellt, dass sie den größten Teil des Bildes richtig wiedergeben kann – bei den extremen Abweichungen in der Helligkeit am Fenster und unter dem Tisch ist dies allerdings nicht mehr möglich. „Die Eventkamera muss sich aber gar nicht für eine Belichtungszeit entscheiden, die sozusagen alle Bildelemente über einen Kamm schert. Jedes Pixel meldet dagegen nach Einschalten der Kamera jeweils, ob und wie stark sich die einfallende Lichtmenge geändert hat“, so Gallego.

Der Dynamikumfang genannt einer Kamera wird in der logarithmischen Einheit Dezibel (dB) angegeben. Während eine professionelle Digitalkamera einen Dynamikumfang von etwa 45 dB aufweist, decken Eventkameras einen Bereich von 120 dB ab. Aufgrund der logarithmischen Skala entspricht dies einer Verbesserung um das 6.000-Fache.

Aufgrund des Wegfalls der Belichtungszeit und der schnellen Reaktionszeit der Pixel im Bereich von Mikrosekunden sind mit Eventkameras auch Hochgeschwindigkeitsaufnahmen möglich, die für Zeitlupenfilme mit extremer Auflösung genutzt werden können. Das typische Maß für Hochgeschwindigkeitsaufnahmen ist die Bildwiederholrate in Bildern pro Sekunde; eine typische Highspeed-Kamera nimmt etwa 10.000 Bilder pro Sekunde auf. Da Eventkameras eben keine ganzen Bilder belichten, muss man für einen Vergleich ihre Performance in eine „virtuelle“ Bildwiederholrate umrechnen. Diese läge bei etwa 200.000 Bildern pro Sekunde – was das Potential der Technik illustriert.

„Eventkameras wurden ursprünglich von Neurowissenschaftlern entwickelt, um ein Modell des menschlichen Sehens zu etablieren“, sagt Friedhelm Hamann, Doktorand am Exzellenzcluster Science of Intelligence. Erst später seien Forschende auf die Idee gekommen, mit ihnen auch fotografische Innovationen voranzutreiben. „Daher hat die herkömmliche Digitalfotografie sowohl auf der Seite der Hardware wie auch bei den Algorithmen zur Bildanalyse mehrere Jahrzehnte Vorsprung.“ Hamann interessiert sich in seiner Doktorarbeit vor allem für letztere. Intelligente Algorithmen sind besonders dann wichtig, wenn aus den Kameradaten Informationen gewonnen werden müssen, etwa für die Orientierung von Robotern im Raum oder autonome Fahrzeuge.

Signalverarbeitung

Ähnlich wie im menschlichen Auge in der Netzhaut findet auch bei den Eventkameras eine erste Informationsverarbeitung durch elektronische Schaltungen direkt hinter den lichtempfindlichen Pixeln statt. Und ähnlich wie es im menschlichen Gehirn vermutet wird, analysieren später Algorithmen die Bildinformationen auf zwei verschiedenen Wegen: Bewegungen von Objekten werden dabei vor allem dadurch erkannt, dass „Kanten“ der Objekte identifiziert und ihre Lageänderungen verfolgt werden. Dies kann sehr schnell im Bereich von unter zweihundert Millisekunden geschehen. Die eigentliche Objekterkennung – um was es sich handeln könnte – nutzt dann vor allem Farben und Formen der Dinge. „Hierfür sind umfassende Trainingsdaten notwendig, die erst nach und nach mit Aufnahmen von Eventkameras gesammelt werden müssen. Auch hier ist uns die normale Digitalfotografie noch weit voraus“, so Friedhelm Hamann.

3D-Ansichten

Nicht alle Tricks der Event-Technologie sind allerdings von der Natur abgeschaut. So hat Guillermo Gallego ein Verfahren entwickelt, mit dem eine einzige Eventkamera 3D-Ansichten liefern kann. Sie wird dazu kontinuierlich mit einer bestimmten Geschwindigkeit bewegt. Dabei liefert fast jedes Pixel ständig neue Daten, weil sich durch die Bewegung der Lichteinfall auf die Pixel dauernd ändert. Wenn man nun die Signale aus der zweidimensionalen Pixel-Ebene zusammen mit der Zeit als dritte Dimension aufträgt, entsteht eine Punktwolke. „Wie kann man daraus auf eine dreidimensionale Szene schließen?“, fragt Gallego rhetorisch. Er dreht die Punktwolke am Computer so lange mit seiner Maus, bis die Anzahl der Punkte plötzlich kleiner erscheint und sie eine dreidimensionale, winkende Person darstellen. „Dabei habe ich intuitiv nichts anderes gemacht, als möglichst viele Punkte jeweils entlang einer Geraden zu orientieren. Übersetzt man dieses Verfahren in einen Algorithmus, kann eine einzelne, bewegte Eventkamera 3D-Bilder liefern.“

Kombination mit herkömmlichen Kameras

„Einige kommerziell erhältliche Eventkameras gibt es bereits. Und gerade Anfang 2023 hat der Technologiekonzern Qualcomm die Zusammenarbeit mit einem Start-up bekanntgegeben, um Eventkameras in Smartphones zu integrieren“, berichtet Gallego. Die Zukunft werde dabei in einer Kombination von Event- und herkömmlichen Digitalkameras liegen, um die Vorteile aus beiden Welten zu vereinen. „Es ist sehr spannend, zu dieser Revolution der Fotografie unseren Anteil beitragen zu können.“

Foto oben: Eine der wenigen kommerziell erhältlichen Eventkameras, hier vom Hersteller iniVation. Sie wird an der TU Berlin für Forschungszwecke eingesetzt.

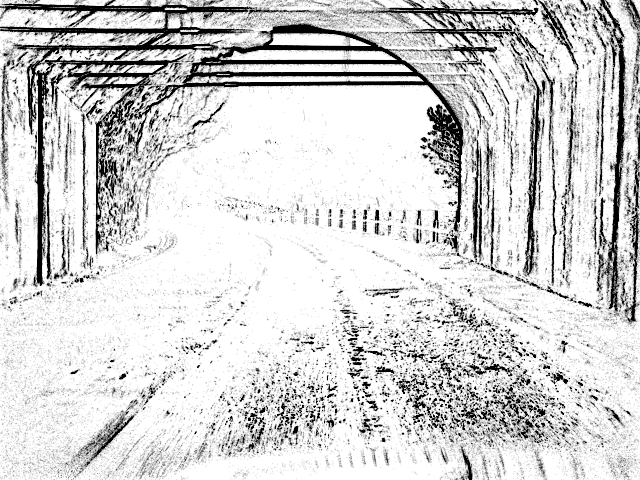

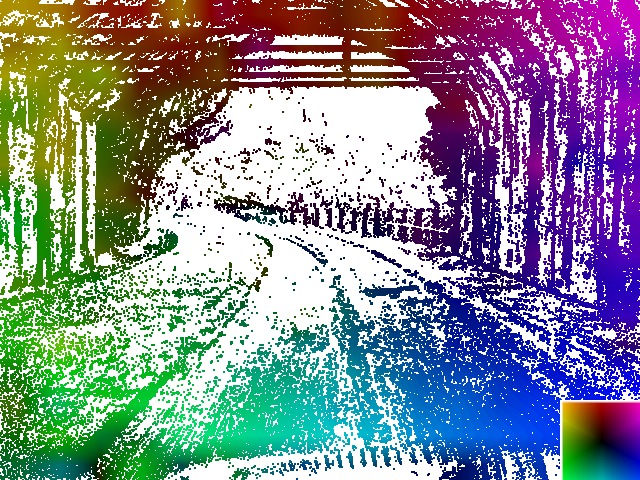

Kameravergleich: Auf dem normalen Foto links ist der Tunnelausgang hell überstrahlt. Mit der Eventkamera (Mitte) erkennt man dagegen aufgrund ihres höheren Dynamikumfangs auch die Fahrstrecke außerhalb des Tunnels. Mit Hilfe schlauer Algorithmen lässt sich aus zwei Eventkamera-Aufnahmen auch ermitteln, welche Teile eines Bildes sich wie schnell wohin bewegen. Dies erkennt man auf dem unteren Bild an den farbigen Pixeln. Mit Hilfe der Legende rechts kann man aus der jeweiligen Farbe Richtung und Tempo ablesen.