KI-Bildgeneratoren haben der Frage nach der Authentizität von Bildern zusätzliche Relevanz verliehen. Viele setzen dabei weitreichende Hoffnungen in das Konzept der Content Authenticity Initiative, CAI, mittels Content Credentials dafür zu bürgen. Was kann CAI leisten, und was nicht?

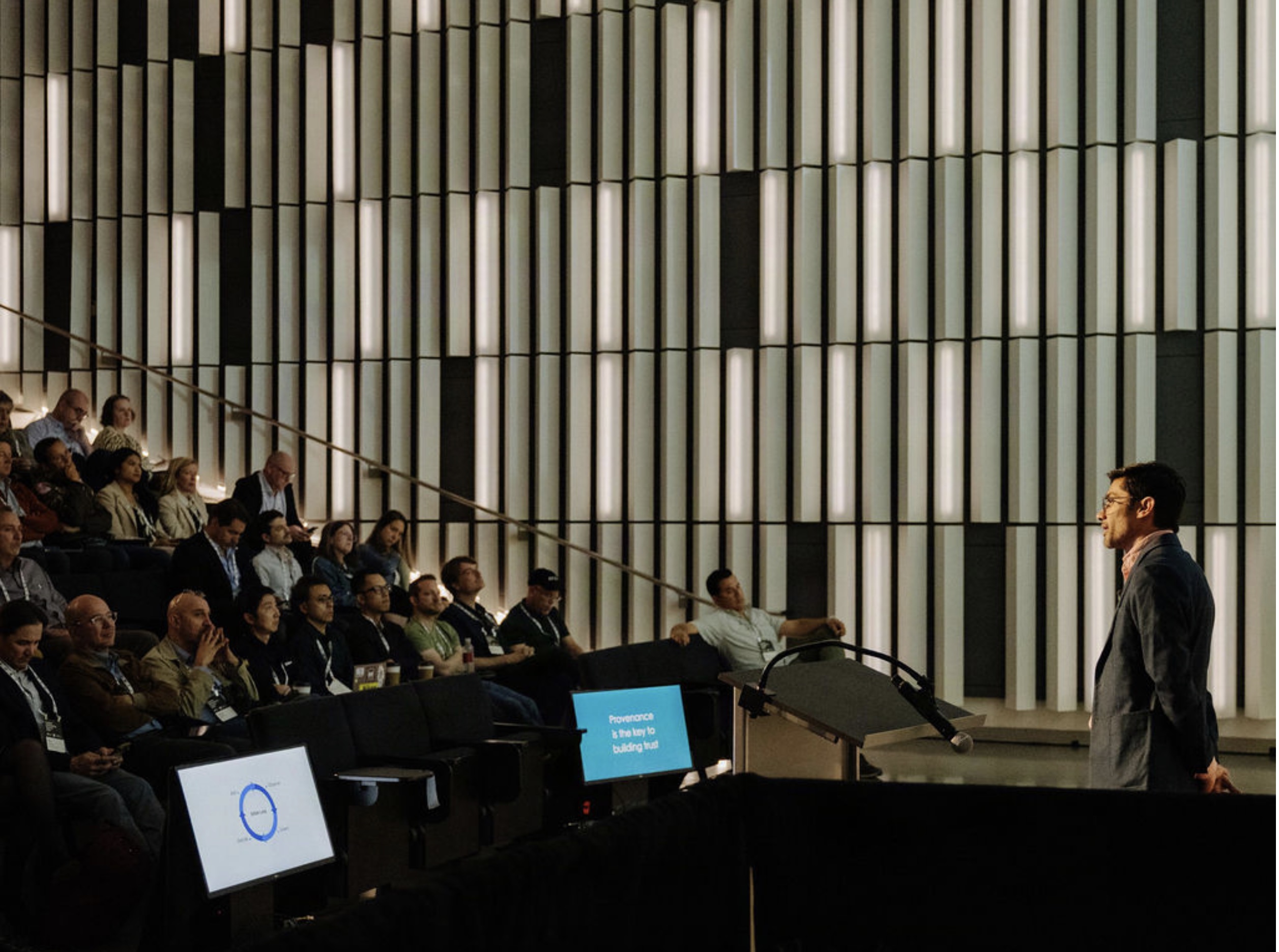

Die Content Authenticity Initiative ist eine Gruppe von Urhebern, Technologie-Spezialisten, Journalisten und Aktivisten, die sich weltweit für die Bekämpfung digitaler Fehlinformationen und die Authentizität von Inhalten einsetzt. Zu den Mitgliedern gehören unter anderem Adobe, Microsoft, The New York Times, Truepic, Qualcomm, Witness, CBC, BBC und viele mehr.

Unter dem Dach der Joint Development Foundation der Linux Foundation kümmert sich die Coalition for Content Provenance and Authenticity (C2PA) im Auftrag der CAI um die Entwicklung entsprechender Standards (SDO).

Die CAI verfolgt dabei drei Möglichkeiten, gegen Fehlinformationen vorzugehen: Aufklärung, Aufdeckung und Zuordnung. Nach mehreren Jahren der Vorarbeit hat die Content Authenticity Initiative aktuell eine öffentliche Beta Version zur Nutzung von Inhaltsurhebernachweisen veröffentlicht. Ziel ist, dass informative, öffentliche und manipulationssichere Daten an alle digitalen Inhalte angehängt werden, wo auch immer sie verwendet werden, damit sie eindeutig und zuverlässig auf ihre Vertrauenswürdigkeit überprüft werden können.

Inhaltsurhebernachweis

Basis ist der sogenannte Inhaltsurhebernachweis (Content Credential), der aus Verlaufs- und Identitätsdaten besteht. Mit Verify können diese Daten angezeigt werden, um zu erfahren, was an ihnen geändert wurde, wo sie verwendet wurden und wer für sie verantwortlich ist.

Der Hauptunterschied zwischen Content Credentials und normalen Metadaten besteht darin, dass die CAI-Technologie eine kryptografische Dateisignierung verwendet. Dieses sogenannte Asset-Hashing kann auch zur Sicherung gängiger Metadaten wie EXIF, IPTC und XMP verwendet werden.

Aktuell bietet die Adobe Photoshop-Funktion „Content Credentials“ (Beta) die Option, Inhaltsnachweise einem Bild hinzuzufügen. Die dazu benötigte Technologie stellt die CAI auch anderen Softwareanbietern im Sinne eines offenen Standards zur Verfügung.

CAI Limits

Dabei geht es der der CAI ausdrücklich nicht um die Verwaltung digitaler Rechte, denn der mit einer Datei verknüpfte Name ist der desjenigen, der diese Daten hinzugefügt hat, also nicht zwangsläufig der Urheber eines Bildes.

Die CAI kann daher im Rahmen ihrer Möglichkeiten nur Aufklärungsarbeit leisten und Informationen liefern, die bei der Aufdeckung helfen können. Um Falschinformationen aber restlos unmöglich zu machen, wäre eine weitergehende Zusammenarbeit innerhalb des größeren Ökosystems digitale Inhalte erforderlich.

Die Hoffnung, KI-generierte Bilder mit Hilfe der CAI-Tools aufdecken zu können, trügt daher, denn auch, wenn ein Urheber KI-Tools verwendet hat, erfolgt die Namensnennung des Users in den Content Credentials.

CAI kann allein schon deshalb keine Aussage darüber treffen, ob ein Bild „gefälscht“ ist, weil das System kein Urteil über den Inhalt eines Bildes treffen kann. Der Standard soll Urhebern lediglich ermöglichen, die Details zur Erstellung eines Bildes transparent zu machen, also wer, was und wie etwas verändert wurde. Der Betrachter muss trotz Content Credentials immer noch selbst beurteilen, wie authentisch das Bild ist.

Außerdem ist es möglich, CAI-Daten aus einer Datei zu entfernen. Hier hilft bei der Recherche dann nur noch, auf der Verify-Website nach möglichen Übereinstimmungen mit anderen Bildern zu suchen.

Auch das in den Credentials angezeigte Datum bezieht sich lediglich auf den Zeitpunkt, an dem die CAI-Daten digital signiert hat oder diese mit angehängten Inhaltsnachweisen exportiert wurde.

Lücken in den CAI-Daten eines Bildes entstehen, wenn ein Anwender ein nicht CAI-unterstütztes Tool verwendet, um es zu bearbeiten, oder wenn er in einem CAI-unterstützten Tool ohne aktivierte CAI-Funktionen arbeitet, denn dann können keine Daten dieser Aktionen erfasst werden. Es erfolgt in diesem Fall lediglich ein Hinweis in den Contant Credentials, dass entsprechende Daten fehlen.

CAI-Daten sind daher nur insofern manipulationssicher, als dass angezeigt wird, wenn etwas unzulässig geändert wurde.

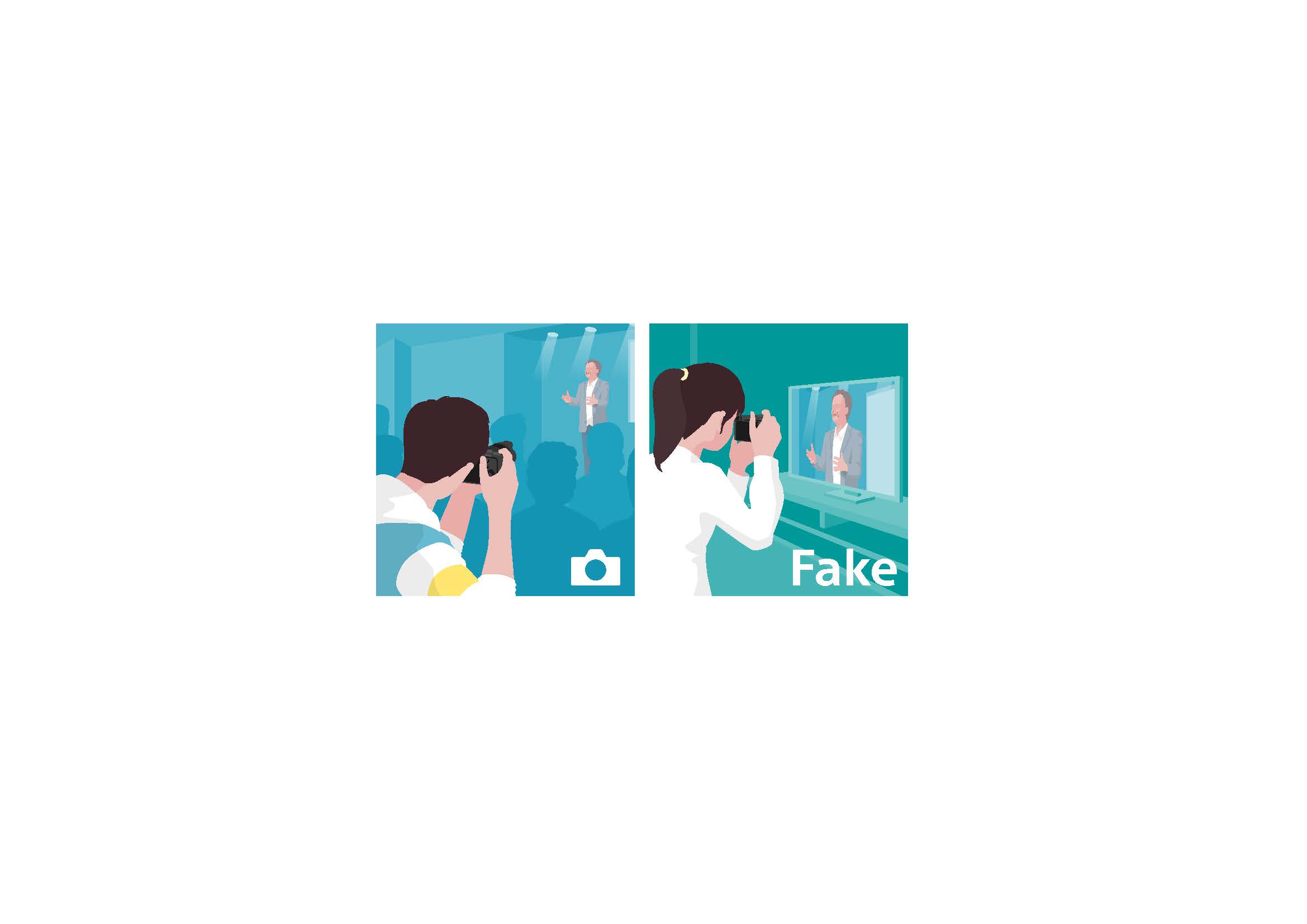

Nicht möglich ist allerdings, einen gefälschten Verlauf von CAI-Daten zu erstellen. Da CAI kryptografisch verifizierbar ist, wird auf der Verify-Website angezeigt, wenn jemand versucht hat, einen solchen Verlauf zu verändern. Allerdings hindert das System niemanden daran, einfach einen Screenshot zu machen und damit weiter zu arbeiten.

Leica und Nikon haben für das laufenden Jahr Firmware-Updates für einige ihrer Kameras angekündigt, die ein Bild schon bei der Aufnahme signieren, so dass das Datum dann auch den Zeitpunkt der Aufnahme angibt. Nur solche Daten gelten gemäß der CAI-Standards als „sicheres Bild“.

Content Credentials Cloud

Die CAI-Daten eines Bildes können nicht nur in der Datei selbst eingebettet, sondern optional auch zentral in der Content Credentials Cloud von Adobe gespeichert werden, die öffentlich und dauerhaft die Attributions- und Verlaufsdaten archiviert. Der Vorteil für Anwender: Dateien werden durch die CAI-Daten nicht aufgebläht und die Content Credentials gehen nicht verloren bzw. sind wiederherstellbar.

Zum Schutz der Privatsphäre werden übrigens keine CAI-Informationen signiert, ohne dass der Benutzer die Funktion ausdrücklich aktiviert hat. Nutzer können generell bestimmen, welche Datenkategorien sie mit ihren Inhalten verknüpfen möchten. Für Personen mit besonderen Datenschutzbedürfnissen (z. B. Menschenrechtsaktivisten in autoritären Ländern) bietet der Standard eine Option zur Schwärzung von PII (Personally Identifiable Information).

Fazit

Die CAI schafft ein System, das lediglich die verwendeten Werkzeuge als auch die Personen, die sie einsetzen, erfasst, um für Transparenz zu sorgen. Sie ist aber nicht dazu geschaffen worden, um Bilder zu beurteilen, sondern kann dazu nur Hinweise liefern. Auf der Webseite der CAI liest man zum Thema KI folgendes: „Künstliche Intelligenz (KI) ist ein leistungsfähiges Werkzeug, das Kreativen helfen wird, ihre Geschichten zu erzählen, aber sie ist nicht selbst kreativ. Hinter dem Einsatz von synthetischen Medien und KI stehen Menschen und Organisationen, die diese Werkzeuge einsetzen.“ Einige von diesen Menschen arbeiten übrigens beim CAI-Initiator Adobe Systems, der zu den Pionieren beim Einsatz von KI in seiner Software gehört und mit Firefly einen eigenes KI-System an den Start gebracht hat. Selbst, wenn erste Kameras verfügbar werden, die den kamerabasierten Ursprung von Bilddaten entsprechend signieren, bietet das keine absolute Sicherheit, denn wer den Print eines synthetisch erzeugten KI-Bildes damit reproduziert, erhält absolut unverdächtige Bilddaten, die als „sicheres Bild“ mit Content Credentials versehen werden können, die den Eindruck von Authentizität erwecken. Die Verantwortung für den korrekten Umgang mit der Wahrheit bleibt daher trotz CAI jedem einzelnen überlassen.

https://verify.contentauthenticity.org